炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

去年WWDC上,被苹果过度宣传又放了鸽子的苹果智能(AppleIntelligence),余味尚存。

就在2025年6月10日凌晨,WWDC25的主演讲(录播)也刚刚结束,与AI有关的部分仍然令人时不时感叹:「就这」。

今年苹果在AI上宣布的诸多所谓新功能,例如实时翻译、快捷指令等,并无太多革命性;至于视觉智能(visualintelligence),不仅功能落后GoogleLens六七年,交互体验上也远未达到一众Android友商的内置AI/Agent产品在2025上半年水平。

但看完全场我可以断言的是:唯有一条关于苹果智能的消息,将带来深远的影响——无论对于普通用户,还是开发者而言。

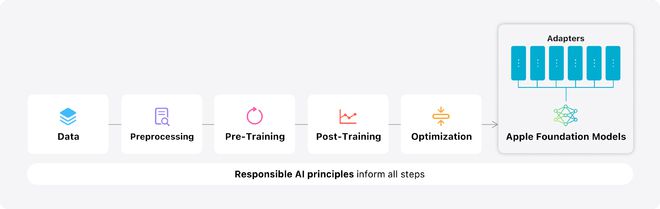

它就是「基础模型框架」(FoundationModelsFramwork),苹果为开发者提供的端侧AI模型接入框架。使用它,苹果开发者将可以轻松地为自己的app接入端侧大语言模型,且无需支付token成本。

这意味着开发者能够无负担为用户提供基于LLM的能力和服务,进行纯端侧的推理,无需担心调用云端LLMAPI产生的token费用,自然也不必将成本转嫁给用户。

开发者能够更体面地维持自己选择的收费模式,用户也因此获益。

苹果智能,纯端侧

去年WWDC,苹果宣布了以「苹果智能」为名的一系列AI产品、功能和可以提供给开发者的技术能力。我们已知这些发布的东西里面大部分都跳票了,甚至完全就是「雾件」(vaporware,指宣布了但严重跳票的软件)。

这的确影响了外界对苹果在AI上到底有几成功力的判断。

但苹果仍然坐拥全球智能手机第一出货量。即便在超大参数量的云端LLM上动作迟缓,这家公司对于人们如何使用AI,以及开发者如何在项目中应用AI技术,仍然有着巨大的话语权——这是客观的、毫无疑问的。

而在今年WWDC25上,我看到了苹果正在行使这种话语权。它告诉开发者:

「基础模型框架」就是苹果交到开发者手上的利器。

基础模型是苹果智能的核心,去年仅用于苹果自家产品和功能使用;而从今天开始,苹果把基础模型开放给开发者,任何第三方应用都可以直接利用这些端侧的基础模型,来实现基于AI的功能,为用户带来崭新的体验。

比如现场展示的「Kahoot!」,一个教育类产品,可以用端侧模型生成针对用户定制化的一套题目;

又或者Alltrails,一款海外徒步玩家必备的产品,即使在深山险境完全无网的情景下,也能为用户提供必要的协助。

https://s3.ifanr.com/wp-content/uploads/2025/06/Apple-WWDC25-Apple-Intelligence-on-device-Foundation-Model-framework_AllTrails-250609.mp4

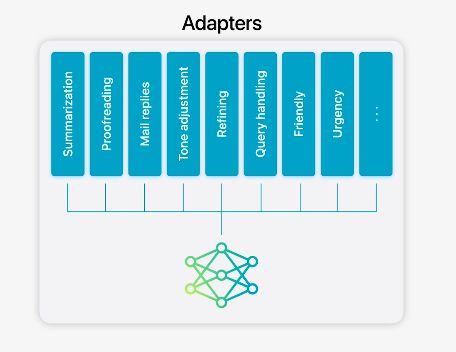

那么,具体都有哪些基础模型?

——已知的至少有这两大类(具体的模型型号未知,苹果目前还没有具体对非开发者提供更具体信息)。目前「基础模型框架」原生支持Swift(其它语言情况未知),开发者只需要几行代码就可以接入,支持内容生成、工具调用等多种LLM能力。

但现如今开发者手上的选择太多了:DeepSeek、Claude、O系列、Gemini……以及它们的各种官方型号和面向具体场景的再训练版,凭什么跟苹果的基础模型玩呢?

苹果给出的价值主张非常直接。

简单来说,使用这些LLM是有直接经济成本的,用户量和活跃度/粘性越大,调用云端API、生成token的成本越高。

面对这种成本,明星创业公司可以通过风投融资,大厂可以使用现金储备来补贴,结果是现如今的用户早已习惯免费的LLM产品了。

但对于中小开发者,特别是独立开发者,这就成了一个非常实际的问题了:想象一下用户刚刚下载你的app,想要浅尝你的AI功能,一上来就看到「本月还有3次免费生成额度」……而如果你的竞争对手里正好有大厂,你怎么和它们竞争?

现在苹果带着「基础模型框架」来到你面前,免费开放端侧模型给你,让你调用iPhone/iPad/Mac的本地算力,快速、高效、且隐私地进行LLM推理,解决用户的需求。

你不再为了支付云端API费用而资金链紧张;不再为了负担token成本而在定价策略上「动作变形」,可以坚定且体面地选择你喜欢的、让用户也感到舒服的商业模式——如果你是个中小或独立开发者,这是不是听起来还挺美好的?

这是一种开发者和用户双赢的局面——当然,加上苹果,那就是三赢。

「虽迟但到」,AI版

知名开发者、苹果分析师JohnGruber前几天写了一篇很有意思的博客文章。

他指出苹果总是在一些关键产品/技术上晚于竞争对手,这也是大家都知道的事情;但你必须承认,在公司存续的历史上,苹果确实也没错过哪次重大的、范式级的科技革命。

比如苹果的Safari浏览器,以及浏览器内核WebKit,推出时间是2003年初,比曾经轰动世界,甚至敢叫嚣让微软生意做不下去的网景浏览器足足晚了8年,甚至比「.com泡沫」破裂都晚了3年——但晚来总比不来好,更别提在Safari之前Mac平台上没有一个好用的浏览器。

如果套用这个逻辑,被迫卷入AI时代的苹果,需要一套在今天能够和Safari/WebKit地位对等的新产品技术组合。

好消息是:正如本文开头提到,iPhone的出货量和市占率优势实在太大了。无论外界怎样嘲讽苹果在AI时代落后,也都无法否认一个现实:

在可预见的相当长一段时间里,苹果仍然有足够的话语权,能够定义用户怎样(在iPhone/iPad/mac/Vision产品上)使用AI,而不是让AI来定义自己的产品应该长什么样。

你能够看到OpenAI收购了前苹果设计领袖JonyIve的公司,试图开发一款「完全AI原生」的新形态设备;但你也会看到OpenAI和苹果达成协议,成为苹果生态里唯一的「全球只是合作伙伴」——也即唯一的外部基础模型供应商。

苹果认为自己落后OpenAI了吗?没有。不然苹果应该给OpenAI交钱。正相反,根据TheInformation报道,OpenAI会像老前辈Google作为iOS默认搜索引擎那样,为了能够进入苹果生态成为默认基础模型,而给苹果交「过路费」。

如果ChatGPT用户订阅月费是20美元的话,苹果抽成有可能高达30%。而且这笔收入几乎等于纯利润。

你看,苹果向OpenAI收钱,然后变相补贴开发者以及终端用户——是不是还挺意外的?

2009年第一财季的苹果财报会上,当时因为乔布斯病重而第二次担任苹果代理CEO的库克,说过几段话,后来被称为「库克信条」。其中有一段是这么说的:

再结合JohnGruber的分析,我把这个思路收敛到一句话:

苹果应该造出一款设备,一种运行AI产品/服务/LLM的载体,然后用这个设备/载体去定义人们怎样使用AI,而不是让AI反过来定义自己该如何开发产品。

在WWDC25之后,外界在观察和评论苹果AI工作的时候,或许可以采用这种新视角。

苹果智能,微更新

最后我们来看一下WWDC25的其他AI新发布内容。

实时翻译

苹果终于在iOS/iPadOS/macOS内集成了一套达到了业界(两三年前)基准水平的实时翻译功能。

目前实时翻译支持信息、电话和FaceTime三个应用。所有翻译可以完全在端侧完成。

Genmoji和ImagePlayground

Genmoji:用户现在可以用LLM提示命令的方式,来生成带有更多新元素的Genmoji头像。比如:把树懒和灯泡合在一起

在ImagePlayground里,用户可以调用ChatGPT的多模态模型生成不同风格或者随机风格的照片——你可以理解为这是一个苹果官方的OpenAI4o套壳。

视觉智能VisualIntelligence

视觉智能之前已经支持摄像头拍照搜索。在今年WWDC上又获得了一个令人无语的更新:支持截图搜索/后续交互了。

比如截图中的物品可以直接调用任意AppStore应用进行搜索,或者对截图中的日期时间地点进行读取,将其添加到日历项、备忘录等。

(现在视觉智能终于追上了Google图片搜索以及Lens在6、7年前已经实现的功能。)

但主要无语的地方在于交互方式太过于古老:截图,而不是像2025上半年的Android手机那样,不用截图就能直接对用户屏幕上的内容进行读取和做出反应,甚至具备agent能力可以直接代替用户操控屏幕。

当然我的理解是苹果这么做可能有两方面原因:1)能力确实不如Google/Android厂商;2)出于隐私方面顾虑,需要用户手动截图、点击视觉智能识别按钮.

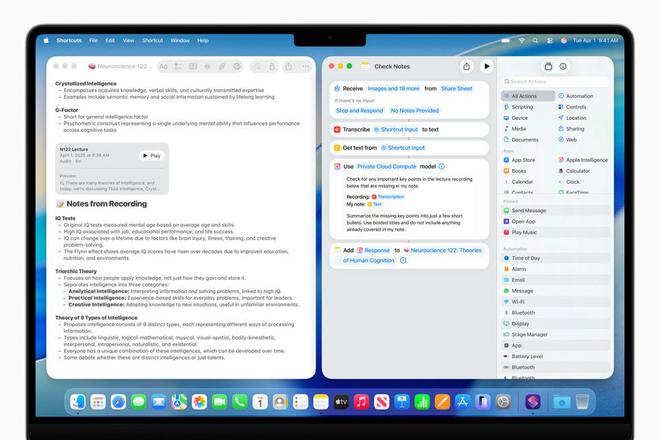

快捷方式

快捷方式(Shortcuts)支持苹果智能了,开发者可以对自己的app进行一些修改和适配,让用户可以快速生成针对app的快捷方式。我不知道多少人会用快捷方式,全世界应该有几十个吧。

海量资讯、精准解读,尽在新浪财经APP

海量资讯、精准解读,尽在新浪财经APP 编辑: 来源: